Meta ra mắt mô hình AI Llama mới

Expert Editor

Meta đã cho ra mắt mô hình trí tuệ nhân tạo (AI) mới nhất có tên là Llama 3.1. Mô hình này có ba phiên bản, với một phiên bản được cho là lớn nhất và mạnh nhất của Llama tính đến nay. Giống như các phiên bản trước đó, Meta tiếp tục cho phép người dùng truy cập vào Llama 3.1 miễn phí, mà không cần đăng ký dịch vụ.

Llama là khoản đầu tư lớn của Meta vào công nghệ AI, nhằm cạnh tranh với các startup như OpenAI và Anthropic, cũng như các gã khổng lồ công nghệ khác như Google và Amazon.

Thông báo này cũng nhấn mạnh mối quan hệ hợp tác ngày càng bền chặt giữa Meta và Nvidia. Nvidia là đối tác chính của Meta. Công ty này cung cấp cho công ty mẹ của Facebook GPU, giúp đào tạo các mô hình AI, trong đó có cả phiên bản mới nhất của Llama.

Trong khi các công ty như OpenAI kiếm tiền từ việc bán quyền truy cập vào các mô hình ngôn ngữ lớn (LLM) độc quyền của họ hoặc cung cấp dịch vụ, giúp khách hàng sử dụng công nghệ, Meta lại không có những kế hoạch như vậy.

Thay vào đó, tương tự như Llama 2 được phát hành vào mùa hè năm ngoái, Meta đang hợp tác với một số công ty công nghệ và cung cấp cho khách hàng của họ quyền truy cập vào Llama 3.1, thông qua các nền tảng điện toán đám mây tương ứng. Đồng thời, công ty cũng bán các công cụ bảo mật và quản lý cho phần mềm mới. Một số đối tác của Meta bao gồm Amazon Web Services, Google Cloud, Microsoft Azure, Databricks và Dell.

CEO của Meta, Mark Zuckerberg, tuyên bố rằng, công ty kiếm được một phần doanh thu từ các quan hệ hợp tác của Llama. Tuy nhiên, phát ngôn viên của Meta cho biết, lợi ích tài chính của các mối quan hệ này lại không đáng kể. Meta đang đầu tư vào Llama và các công nghệ AI có liên quan, cũng như cung cấp chúng miễn phí thông qua mã nguồn mở. Công ty tin rằng có thể thu hút nhân tài chất lượng cao trong một thị trường đầy cạnh tranh và giảm chi phí cơ sở hạ tầng điện toán, đi kèm với các lợi ích khác.

Llama 3.1 được ra mắt trước thềm hội nghị đồ họa máy tính tiên tiến, sự kiện mà Zuckerberg và CEO của Nvidia, Jensen Huang, dự kiến sẽ phát biểu cùng nhau.

Gã khổng lồ mạng xã hội là một trong những khách hàng cao cấp nhất của Nvidia, mà không vận hành hệ thống đám mây riêng cho doanh nghiệp. Ngoài ra, Meta cũng cần con chip mới nhất, để đào tạo những mô hình AI, và sử dụng nội bộ cho các mục đích và sản phẩm khác. Ví dụ, phiên bản lớn nhất của mô hình Llama 3.1 đã được đào tạo bằng 16.000 bộ xử lý đồ họa H100 của Nvidia.

Mặt khác, đối với Nvidia, việc Meta đào tạo các mô hình AI và ứng dụng nguồn mở, cho phép các công ty khác sử dụng và điều chỉnh sao cho phù hợp với doanh nghiệp của mình, mà không phải trả phí bản quyền hoặc xin phép, giúp các con chip của Nvidia được sử dụng rộng rãi và nhu cầu luôn giữ ở mức cao.

Tuy nhiên, các mô hình AI sử dụng nguồn mở có thể tiêu tốn hàng trăm triệu hoặc hàng tỷ USD để tạo ra. Không có nhiều công ty đủ tài chính để phát triển và phát hành các mô hình như vậy với mức đầu tư tương tự. Chẳng hạn, Google và OpenAI, mặc dù cũng là khách hàng của Nvidia, vẫn hạn chế quyền truy cập đối với các mô hình tiên tiến nhất của họ.

Ngược lại, Meta cần nguồn cung GPU ổn định, để đào tạo các mô hình ngày càng phát triển mạnh mẽ. Giống như Nvidia, Meta đang cố gắng thúc đẩy một hệ sinh thái với các nhà phát triển ứng dụng AI sử dụng phần mềm của công ty làm trung tâm, ngay cả khi Meta phải cung cấp mã và những thứ được gọi là AI weight rất tốn kém để xây dựng.

Ash Jhaveri, phó chủ tịch mảng quan hệ đối tác AI của Meta, chia sẻ với trang tin CNBC rằng, sử dụng nguồn mở mang lại lợi ích cho Meta, thông qua việc giới thiệu các công cụ nội bộ của công ty với các nhà phát triển và mời họ xây dựng trên đó. Điều này cũng cho phép Meta tiếp cận những cải tiến mới do cộng đồng nhà phát triển tạo ra.

Zuckerberg viết trong một bài đăng trên blog rằng, công ty đang thực hiện một “cách tiếp cận khác” khi phát hành Llama. Vị CEO này cũng bổ sung, “Chúng tôi đang tích cực phát triển các quan hệ đối tác, để những công ty trong hệ sinh thái có thể cung cấp trải nghiệm độc đáo cho khách hàng.”

Phiên bản lớn nhất của mô hình Llama 3.1 được gọi là Llama 3.1 405B. Mô hình LLM này chứa 405 tỷ tham số. Đây là số lượng các biến số quyết định kích thước tổng thể của mô hình và lượng dữ liệu mà nó có thể xử lý.

Nói chung, một LLM lớn với số lượng tham số cao có thể thực hiện các tác vụ phức tạp hơn so với các LLM nhỏ. Chẳng hạn, LLM này có thể hiểu ngữ cảnh trong các đoạn văn dài, giải quyết các phương trình toán học phức tạp và thậm chí tạo ra dữ liệu tổng hợp, giúp cải thiện các mô hình AI nhỏ hơn.

Meta cũng phát hành các phiên bản nhỏ hơn của Llama 3.1, được gọi là mô hình Llama 3.1 8B và Llama 3.1 70B. Về cơ bản, đây là hai phiên bản nâng cấp của các mô hình trước đó. Chúng có thể được sử dụng để vận hành các chatbot và hỗ trợ lập trình phần mềm.

Meta cũng cho biết, người dùng WhatsApp ở Hoa Kỳ và khách truy cập vào trang web Meta.AI sẽ có thể sử dụng Llama 3.1, bằng cách tương tác với trợ lý ảo của công ty. Trợ lý ảo này sẽ sử dụng phiên bản mới nhất của Llama và có thể trả lời các bài toán phức tạp hoặc giải quyết các vấn đề khi lập trình phần mềm.

Ngoài ra, người dùng sẽ có thể chuyển đổi giữa các mô hình Llama để có được câu trả lời phù hợp cho các câu hỏi của mình.

ABOUT THE AUTHOR

Expert Editor

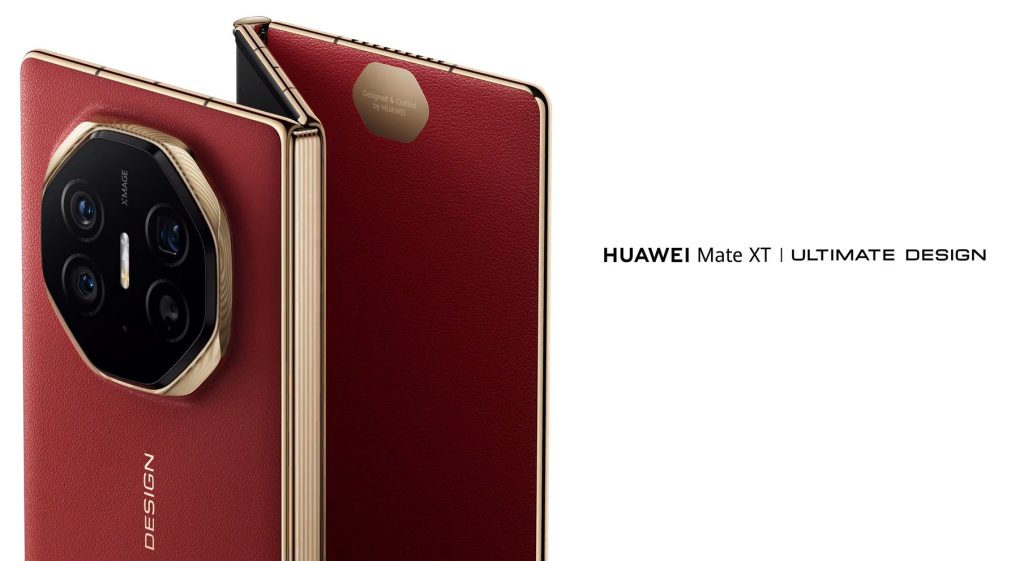

Huawei sẽ ra mắt sản phẩm mới đối đầu trực tiếp với iPhone 16 của Apple

Expert Editor

Căng thẳng Mỹ-Trung đe dọa sự phát triển của ngành năng lượng mặt trời ở Đông Nam Á

Expert Editor

ASEAN đặt mục tiêu trở thành nền kinh tế lớn thứ tư thế giới

Expert Editor